Détails de la leçon

Description de la leçon

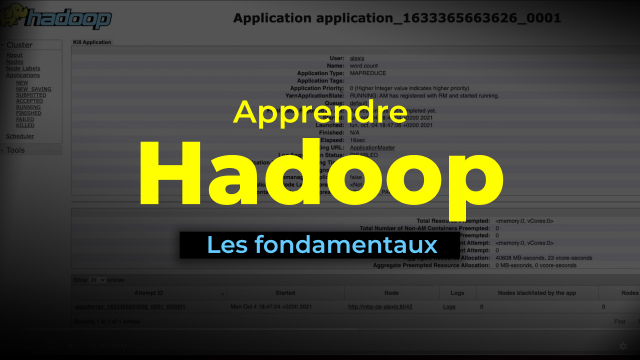

Cette leçon vous guide étape par étape à travers le processus de création et d'exécution d'un programme MapReduce avec Hadoop. Nous commençons par la configuration initiale, où nous créons un répertoire nommé WordCount sur HDFS et y ajoutons les fichiers nécessaires. Ensuite, nous illustrons la création de fichiers texte en local qui serviront d'input pour notre programme.

Nous expliquons en détail le code source du programme, mettant en évidence les classes Map et Reduce, ainsi que la configuration nécessaire pour passer les chemins d'entrée et de sortie lors de l'exécution. Une fois le fichier Java compilé et transformé en jar, nous montrons comment le déployer et l'exécuter sur Hadoop, en spécifiant les chemins appropriés sur HDFS.

Enfin, nous présentons la méthode pour vérifier et afficher les résultats de notre programme via l'interface du NameNode et l'utilisation des commandes HDFS. Cette approche pratique garantit que vous pouvez appliquer ce savoir-faire à vos propres projets.

Objectifs de cette leçon

Les objectifs de cette vidéo sont de :

- Comprendre la structure et l'exécution d'un programme MapReduce.

- Apprendre à manipuler le système de fichiers HDFS pour préparer l'environnement d'exécution.

- Savoir compiler et exécuter des programmes Java sur Hadoop.

Prérequis pour cette leçon

Pour suivre cette vidéo, vous devez :

- Avoir une connaissance de base en programmation Java.

- Comprendre les concepts fondamentaux de Hadoop et de HDFS.

- Savoir utiliser des lignes de commande de base pour gérer des répertoires et des fichiers.

Métiers concernés

Ce savoir-faire est particulièrement pertinent pour :

- Data Engineers : qui conçoivent et maintiennent des systèmes de traitement de données.

- Data Scientists : cherchant à analyser de grandes quantités de données.

- Administrateurs systèmes : responsables de la configuration et de la gestion des clusters Hadoop.

Alternatives et ressources

Parmi les alternatives possibles, vous pouvez explorer :

- Apache Spark : pour des traitements de données plus rapides et en temps réel.

- Flink : pour des flux de données en continu et des calculs distribués.